每日經濟新聞 2023-11-14 17:26:41

每經記者 楊卉 每經編輯 董興生

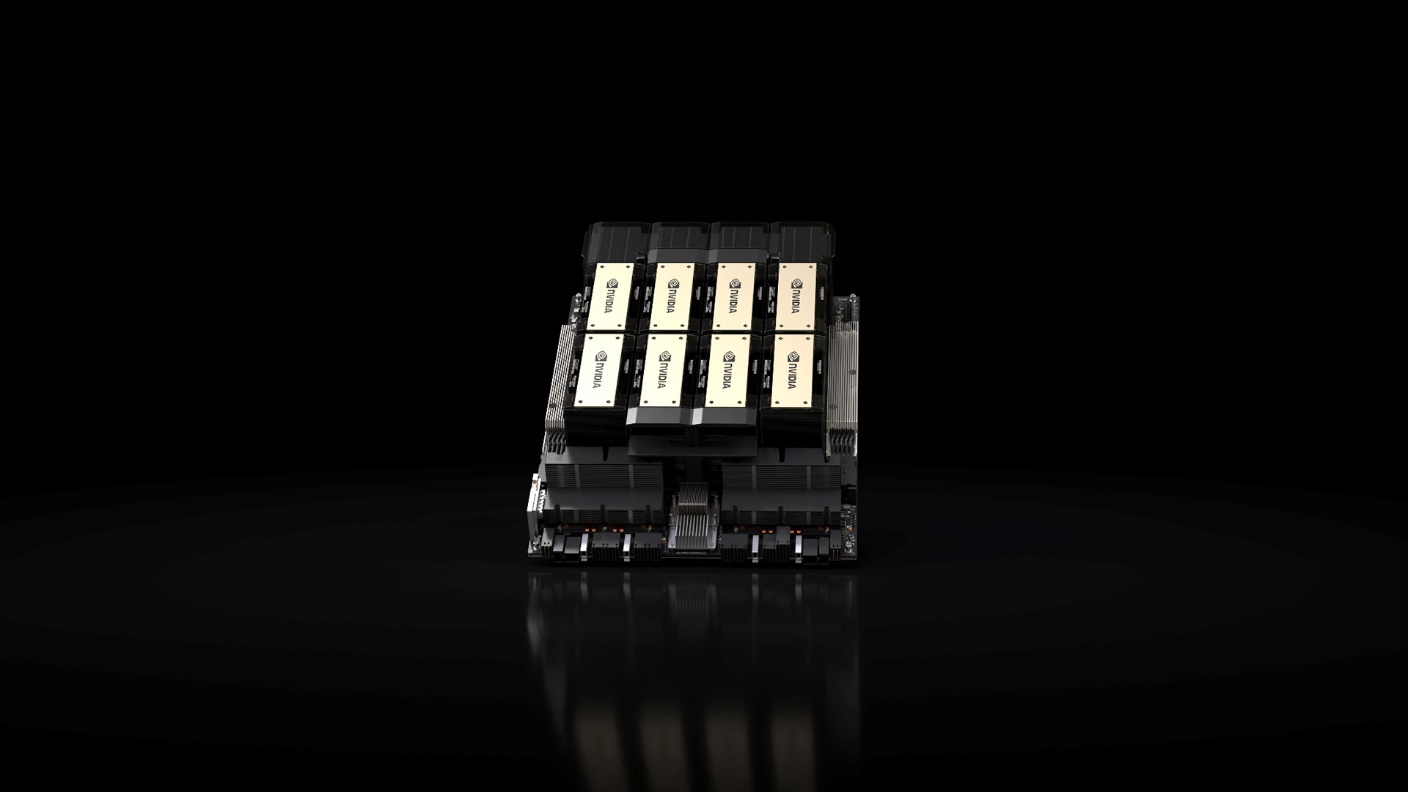

黃仁勛又升級“裝備”了。11月14日,《每日經濟新聞》記者從英偉達處獲悉,當地時間11月13日,英偉達宣布推出NVIDIA HGX™ H200(AI芯片型號,以下簡稱“H200”)。據悉,H200是首款采用HBM3e GPU(內存,相較此前速率更快、容量更大),進一步加速生成式AI與大語言模型,同時推進用于HPC(高性能計算)工作負載的科學計算,可提供傳輸速度4.8 TB/秒的141GB顯存,與上一代架構的NVIDIA A100相比容量翻了近一倍,帶寬增加了2.4倍。

圖片來源:企業供圖

在英偉達超大規模和高性能計算副總裁Ian Buck看來,想要通過生成式AI和HPC應用創造智能,就必須使用大型、快速的GPU顯存來高速、高效地處理海量數據。當H200與采用超高速NVLink-C2C互連技術的NVIDIA Grace CPU搭配使用時,就組成了帶有HBM3e的GH200 Grace™ Hopper超級芯片——專為大型HPC和AI應用而設計的計算模塊。

從規格來看,H200將提供四路和八路H200服務器主板可選,與HGX H100系統的硬件和軟件都兼容;還可用于今年8月發布的采用HBM3e的NVIDIA GH200 Grace Hopper™超級芯片。這些配置使H200可以部署在各類數據中心,包括本地、云、混合云和邊緣;可為各種應用工作負載提供最高的性能,包括針對1750億參數以上超大模型的LLM訓練和推理。

架構方面,與前代相比,NVIDIA Hopper架構實現了性能躍升,如在一個700億參數的LLM——Llama 2上的推理速度比H100(英偉達AI芯片)提高了近一倍。

根據英偉達方面的說法,將于2024年第二季度開始通過全球系統制造商和云服務提供商提供H200;服務器制造商和云服務提供商也預計于同一時間開始提供搭載H200的系統。

如需轉載請與《每日經濟新聞》報社聯系。

未經《每日經濟新聞》報社授權,嚴禁轉載或鏡像,違者必究。

讀者熱線:4008890008

特別提醒:如果我們使用了您的圖片,請作者與本站聯系索取稿酬。如您不希望作品出現在本站,可聯系我們要求撤下您的作品。

歡迎關注每日經濟新聞APP